English | 简体中文 | 繁體中文 | 한국어 | Español | 日本語 | हिन्दी | Русский | Рortuguês | తెలుగు | Français | Deutsch | Tiếng Việt |

Apprentissage automatique de pointe pour JAX, PyTorch et TensorFlow

🤗 Transformers fournit des milliers de modèles pré-entraînés pour effectuer des tâches sur différentes modalités telles que le texte, la vision et l'audio.

Ces modèles peuvent être appliqués à :

Les modèles de transformer peuvent également effectuer des tâches sur plusieurs modalités combinées, telles que la réponse aux questions sur des tableaux, la reconnaissance optique de caractères, l'extraction d'informations à partir de documents numérisés, la classification vidéo et la réponse aux questions visuelles.

🤗 Transformers fournit des API pour télécharger et utiliser rapidement ces modèles pré-entraînés sur un texte donné, les affiner sur vos propres ensembles de données, puis les partager avec la communauté sur notre hub de modèles. En même temps, chaque module Python définissant une architecture est complètement indépendant et peut être modifié pour permettre des expériences de recherche rapides.

🤗 Transformers est soutenu par les trois bibliothèques d'apprentissage profond les plus populaires — Jax, PyTorch et TensorFlow — avec une intégration transparente entre eux. Il est facile de former vos modèles avec l'un avant de les charger pour l'inférence avec l'autre.

Vous pouvez tester la plupart de nos modèles directement sur leurs pages du hub de modèles. Nous proposons également l'hébergement privé de modèles, le versionning et une API d'inférence pour des modèles publics et privés.

Voici quelques exemples :

En traitement du langage naturel :

En vision par ordinateur :

En audio :

Dans les tâches multimodales :

Transformers est plus qu'une boîte à outils pour utiliser des modèles pré-entraînés : c'est une communauté de projets construits autour de lui et du Hub Hugging Face. Nous voulons que Transformers permette aux développeurs, chercheurs, étudiants, professeurs, ingénieurs et à quiconque d'imaginer et de réaliser leurs projets de rêve.

Afin de célébrer les 100 000 étoiles de transformers, nous avons décidé de mettre en avant la communauté et avons créé la page awesome-transformers qui répertorie 100 projets incroyables construits autour de transformers.

Si vous possédez ou utilisez un projet que vous pensez devoir figurer dans la liste, veuillez ouvrir une pull request pour l'ajouter !

Pour utiliser immédiatement un modèle sur une entrée donnée (texte, image, audio,...), nous fournissons l'API pipeline. Les pipelines regroupent un modèle pré-entraîné avec la préparation des données qui a été utilisée lors de l'entraînement de ce modèle. Voici comment utiliser rapidement un pipeline pour classer des textes en positif ou négatif :

>>> from transformers import pipeline

# Allouer un pipeline pour l'analyse de sentiment

>>> classifieur = pipeline('sentiment-analysis')

>>> classifieur("Nous sommes très heureux d'introduire le pipeline dans le référentiel transformers.")

[{'label': 'POSITIF', 'score': 0.9996980428695679}]

La deuxième ligne de code télécharge et met en cache le modèle pré-entraîné utilisé par le pipeline, tandis que la troisième l'évalue sur le texte donné. Ici, la réponse est "positive" avec une confiance de 99,97%.

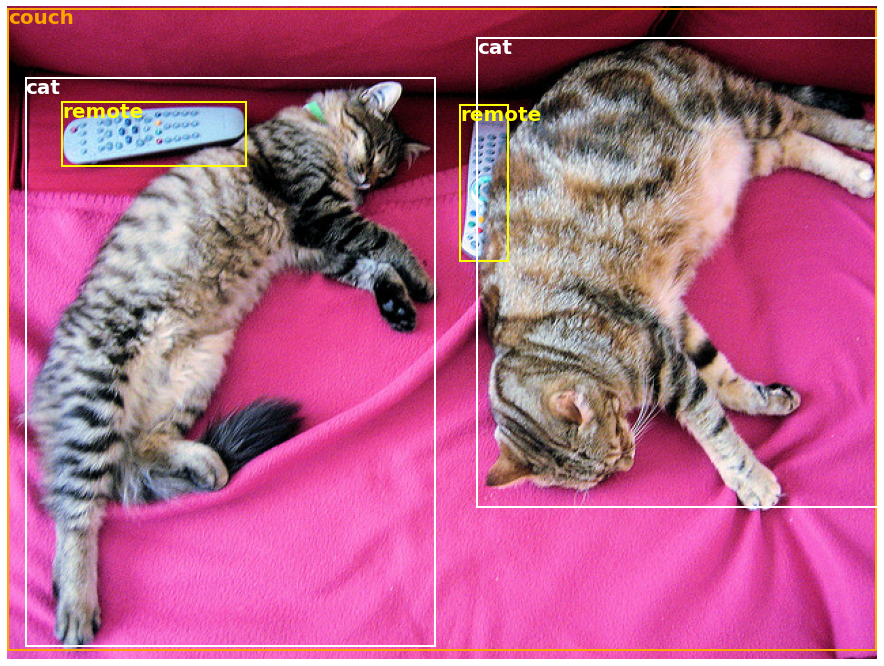

De nombreuses tâches ont une pipeline pré-entraîné prêt à l'emploi, en NLP, mais aussi en vision par ordinateur et en parole. Par exemple, nous pouvons facilement extraire les objets détectés dans une image :

>>> import requests

>>> from PIL import Image

>>> from transformers import pipeline

# Télécharger une image avec de jolis chats

>>> url = "https://huggingface.co/datasets/huggingface/documentation-images/resolve/main/coco_sample.png"

>>> donnees_image = requests.get(url, stream=True).raw

>>> image = Image.open(donnees_image)

# Allouer un pipeline pour la détection d'objets

>>> detecteur_objets = pipeline('object-detection')

>>> detecteur_objets(image)

[{'score': 0.9982201457023621,

'label': 'télécommande',

'box': {'xmin': 40, 'ymin': 70, 'xmax': 175, 'ymax': 117}},

{'score': 0.9960021376609802,

'label': 'télécommande',

'box': {'xmin': 333, 'ymin': 72, 'xmax': 368, 'ymax': 187}},

{'score': 0.9954745173454285,

'label': 'canapé',

'box': {'xmin': 0, 'ymin': 1, 'xmax': 639, 'ymax': 473}},

{'score': 0.9988006353378296,

'label': 'chat',

'box': {'xmin': 13, 'ymin': 52, 'xmax': 314, 'ymax': 470}},

{'score': 0.9986783862113953,

'label': 'chat',

'box': {'xmin': 345, 'ymin': 23, 'xmax': 640, 'ymax': 368}}]

Ici, nous obtenons une liste d'objets détectés dans l'image, avec une boîte entourant l'objet et un score de confiance. Voici l'image originale à gauche, avec les prédictions affichées à droite :

Vous pouvez en savoir plus sur les tâches supportées par l'API pipeline dans ce tutoriel.

En plus de pipeline, pour télécharger et utiliser n'importe lequel des modèles pré-entraînés sur votre tâche donnée, il suffit de trois lignes de code. Voici la version PyTorch :

>>> from transformers import AutoTokenizer, AutoModel

>>> tokenizer = AutoTokenizer.from_pretrained("google-bert/bert-base-uncased")

>>> model = AutoModel.from_pretrained("google-bert/bert-base-uncased")

inputs = tokenizer("Bonjour le monde !", return_tensors="pt")

outputs = model(**inputs)

Et voici le code équivalent pour TensorFlow :

from transformers import AutoTokenizer, TFAutoModel

tokenizer = AutoTokenizer.from_pretrained("google-bert/bert-base-uncased")

model = TFAutoModel.from_pretrained("google-bert/bert-base-uncased")

inputs = tokenizer("Bonjour le monde !", return_tensors="tf")

outputs = model(**inputs)

Le tokenizer est responsable de toutes les étapes de prétraitement que le modèle préentraîné attend et peut être appelé directement sur une seule chaîne de caractères (comme dans les exemples ci-dessus) ou sur une liste. Il produira un dictionnaire que vous pouvez utiliser dans votre code ou simplement passer directement à votre modèle en utilisant l'opérateur de déballage **.

Le modèle lui-même est un module nn.Module PyTorch ou un modèle tf.keras.Model TensorFlow (selon votre backend) que vous pouvez utiliser comme d'habitude. Ce tutoriel explique comment intégrer un tel modèle dans une boucle d'entraînement classique PyTorch ou TensorFlow, ou comment utiliser notre API Trainer pour affiner rapidement sur un nouvel ensemble de données.

Des modèles de pointe faciles à utiliser :

Coûts informatiques réduits, empreinte carbone plus petite :

Choisissez le bon framework pour chaque partie de la vie d'un modèle :

Personnalisez facilement un modèle ou un exemple selon vos besoins :

Ce référentiel est testé sur Python 3.8+, Flax 0.4.1+, PyTorch 1.11+ et TensorFlow 2.6+.

Vous devriez installer 🤗 Transformers dans un environnement virtuel. Si vous n'êtes pas familier avec les environnements virtuels Python, consultez le guide utilisateur.

D'abord, créez un environnement virtuel avec la version de Python que vous allez utiliser et activez-le.

Ensuite, vous devrez installer au moins l'un de Flax, PyTorch ou TensorFlow. Veuillez vous référer à la page d'installation de TensorFlow, de PyTorch et/ou de Flax et Jax pour connaître la commande d'installation spécifique à votre plateforme.

Lorsqu'un de ces backends est installé, 🤗 Transformers peut être installé avec pip comme suit :

pip install transformers

Si vous souhaitez jouer avec les exemples ou avez besoin de la dernière version du code et ne pouvez pas attendre une nouvelle version, vous devez installer la bibliothèque à partir de la source.

🤗 Transformers peut être installé avec conda comme suit :

conda install conda-forge::transformers

NOTE: L'installation de

transformersdepuis le canalhuggingfaceest obsolète.

Suivez les pages d'installation de Flax, PyTorch ou TensorFlow pour voir comment les installer avec conda.

NOTE: Sur Windows, on peut vous demander d'activer le mode développeur pour bénéficier de la mise en cache. Si ce n'est pas une option pour vous, veuillez nous le faire savoir dans cette issue.

Tous les points de contrôle de modèle fournis par 🤗 Transformers sont intégrés de manière transparente depuis le hub de modèles huggingface.co, où ils sont téléchargés directement par les utilisateurs et les organisations.

Nombre actuel de points de contrôle :

🤗 Transformers fournit actuellement les architectures suivantes: consultez ici pour un résumé global de chacune d'entre elles.

Pour vérifier si chaque modèle a une implémentation en Flax, PyTorch ou TensorFlow, ou s'il a un tokenizer associé pris en charge par la bibliothèque 🤗 Tokenizers, consultez ce tableau.

Ces implémentations ont été testées sur plusieurs ensembles de données (voir les scripts d'exemple) et devraient correspondre aux performances des implémentations originales. Vous pouvez trouver plus de détails sur les performances dans la section Exemples de la documentation.

| Section | Description |

|---|---|

| Documentation | Documentation complète de l'API et tutoriels |

| Résumé des tâches | Tâches prises en charge par les 🤗 Transformers |

| Tutoriel de prétraitement | Utilisation de la classe Tokenizer pour préparer les données pour les modèles |

| Entraînement et ajustement fin | Utilisation des modèles fournis par les 🤗 Transformers dans une boucle d'entraînement PyTorch/TensorFlow et de l'API Trainer

|

| Tour rapide : Scripts d'ajustement fin/d'utilisation | Scripts d'exemple pour ajuster finement les modèles sur une large gamme de tâches |

| Partage et téléversement de modèles | Téléchargez et partagez vos modèles ajustés avec la communauté |

Nous disposons désormais d'un article que vous pouvez citer pour la bibliothèque 🤗 Transformers :

@inproceedings{wolf-etal-2020-transformers,

title = "Transformers: State-of-the-Art Natural Language Processing",

author = "Thomas Wolf and Lysandre Debut and Victor Sanh and Julien Chaumond and Clement Delangue and Anthony Moi and Pierric Cistac and Tim Rault and Rémi Louf and Morgan Funtowicz and Joe Davison and Sam Shleifer and Patrick von Platen and Clara Ma and Yacine Jernite and Julien Plu and Canwen Xu and Teven Le Scao and Sylvain Gugger and Mariama Drame and Quentin Lhoest and Alexander M. Rush",

booktitle = "Proceedings of the 2020 Conference on Empirical Methods in Natural Language Processing: System Demonstrations",

month = oct,

year = "2020",

address = "Online",

publisher = "Association for Computational Linguistics",

url = "https://www.aclweb.org/anthology/2020.emnlp-demos.6",

pages = "38--45"

}

此处可能存在不合适展示的内容,页面不予展示。您可通过相关编辑功能自查并修改。

如您确认内容无涉及 不当用语 / 纯广告导流 / 暴力 / 低俗色情 / 侵权 / 盗版 / 虚假 / 无价值内容或违法国家有关法律法规的内容,可点击提交进行申诉,我们将尽快为您处理。